Google veröffentlicht Gemini 2.5 Flash: Ermöglicht flexiblere Gedankenkontrolle

Im harten Wettbewerb um künstliche Intelligenz schreibt Google mit einer bahnbrechenden Innovation einmal mehr das Buch neu

Erfahren Sie mehr über Claude und ChatGPTs aktuelle Nachrichten und Informationen über große Modelle. Dieser Blog konzentriert sich auf die Verfolgung und Analyse des aktuellen Stands der Technik von Large Language Models (LLMs), technologische Updates und ihre praktischen Anwendungen in verschiedenen Bereichen.

Insgesamt Ergebnisse

Kein Datensatz gefunden

Im harten Wettbewerb um künstliche Intelligenz schreibt Google mit einer bahnbrechenden Innovation einmal mehr das Buch neu

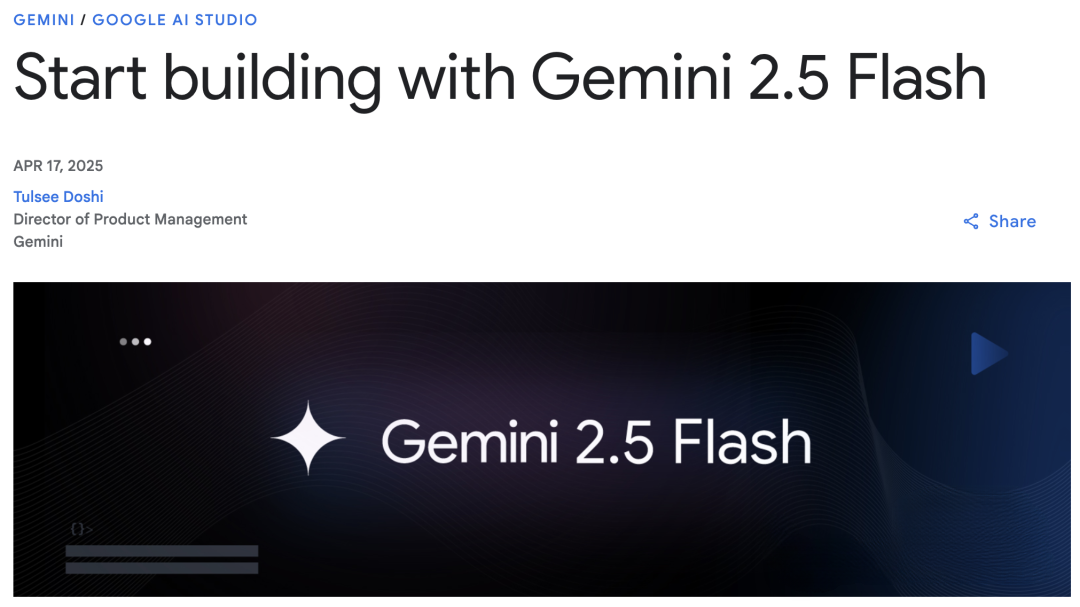

Am 17. April 2025 war OpenAI live bei Late Night Live im

I. Einleitung Am 15. April 2025 wurde OpenAI offiziell

I. Technologischer Durchbruch: Ein qualitativer Sprung vom Labor zur API Google Deep

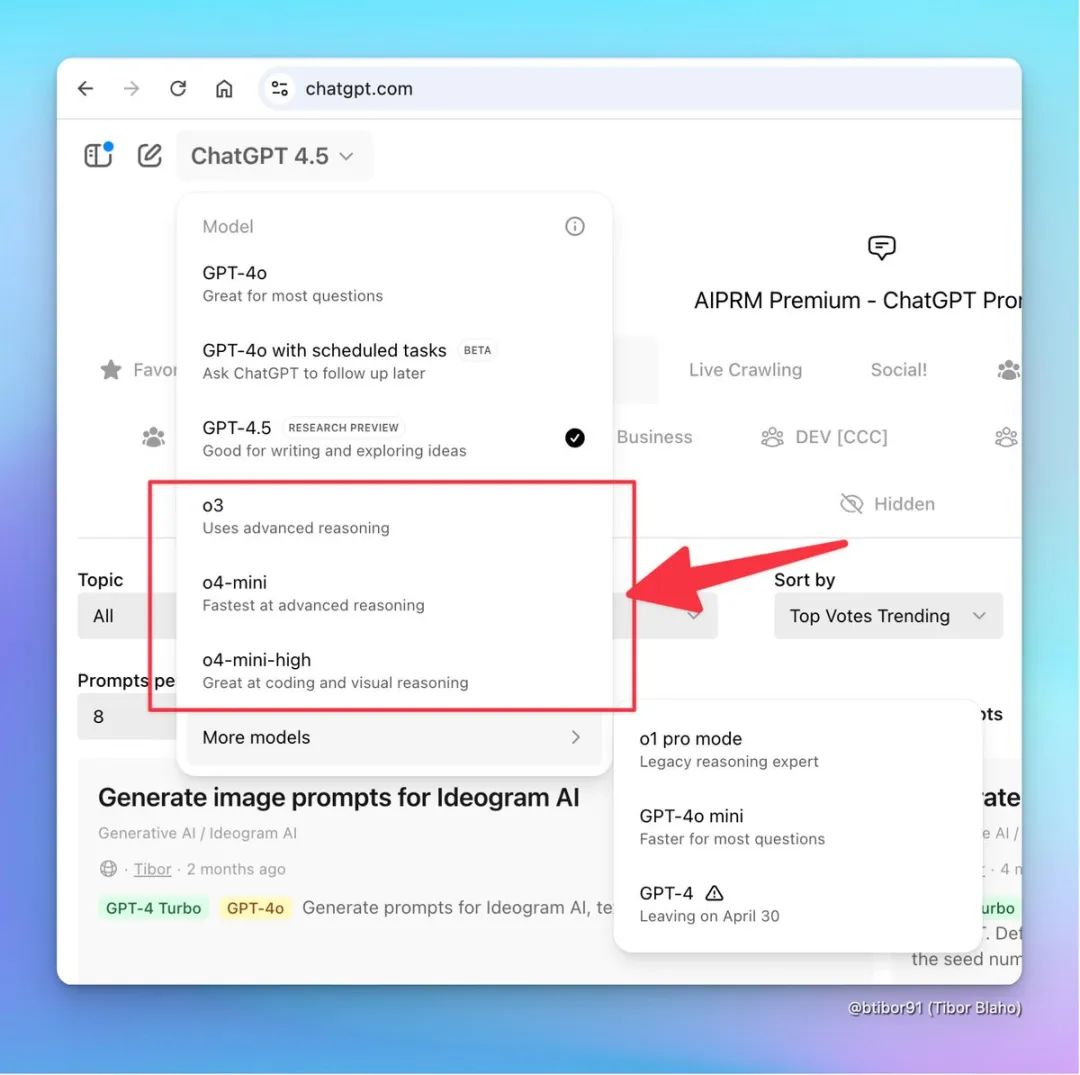

I. Einleitung Kürzlich hat die "Dark Side of the Moon"-Technologie (Moonshot AI) offiziell die

I. Einleitung Entdecken Sie ein aggregiertes KI-Produkt: die AI Cloud Native Platform. Sie ist nicht nur perfekt, sondern auch

Haben Sie jemals von einem KI-Assistenten geträumt, der nicht nur mit Ihnen plaudert, sondern auch wie ein professioneller Datenwissenschaftler handelt?

I. Einleitung Als führendes Unternehmen in der KI-Branche hat OpenAI mit seiner neuesten 4o

I. EINLEITUNG In der heutigen Ära der schnellen KI-Entwicklung werden die verschiedenen großen Sprachmodelle ständig weiterentwickelt und immer mehr

I. EINLEITUNG Mit der raschen Entwicklung der künstlichen Intelligenz in allen Lebensbereichen, insbesondere bei der Programmierung und Erstellung von

I. Einleitung Am 19. März 2025 veröffentlichte Google offiziell das Gemini C

Einleitung In der heutigen, sich schnell entwickelnden KI-Ära werden Top-KI-Modelle wie GPT P

Einleitung Auf der Welle der künstlichen Intelligenz ist Manus für seine Exzellenz und Innovation bekannt

I. Einleitung Mit der rasanten Entwicklung der Technologie der künstlichen Intelligenz sind die KI-Sprachassistenten zu unseren

I. Einführung Gemini Code Assist ist eine Software von Gemini Code Assist, die von G

I. Einleitung In den letzten Jahren haben sich mit der raschen Entwicklung der Technologie der künstlichen Intelligenz die wichtigsten Sprachmodelle der

EINLEITUNG Mit der rasanten Entwicklung der KI-Technologie wurden groß angelegte Sprachmodelle (LLMs)

Grok3 Hintergrund und Funktionen Grok3 ist das Flaggschiff unter den KI-Modellen von xAI und wurde entwickelt, um

Mit der rasanten Entwicklung der KI-Technologie werden API-Dienste allmählich zu einer Schlüsselkomponente für Entwickler und Unternehmen.

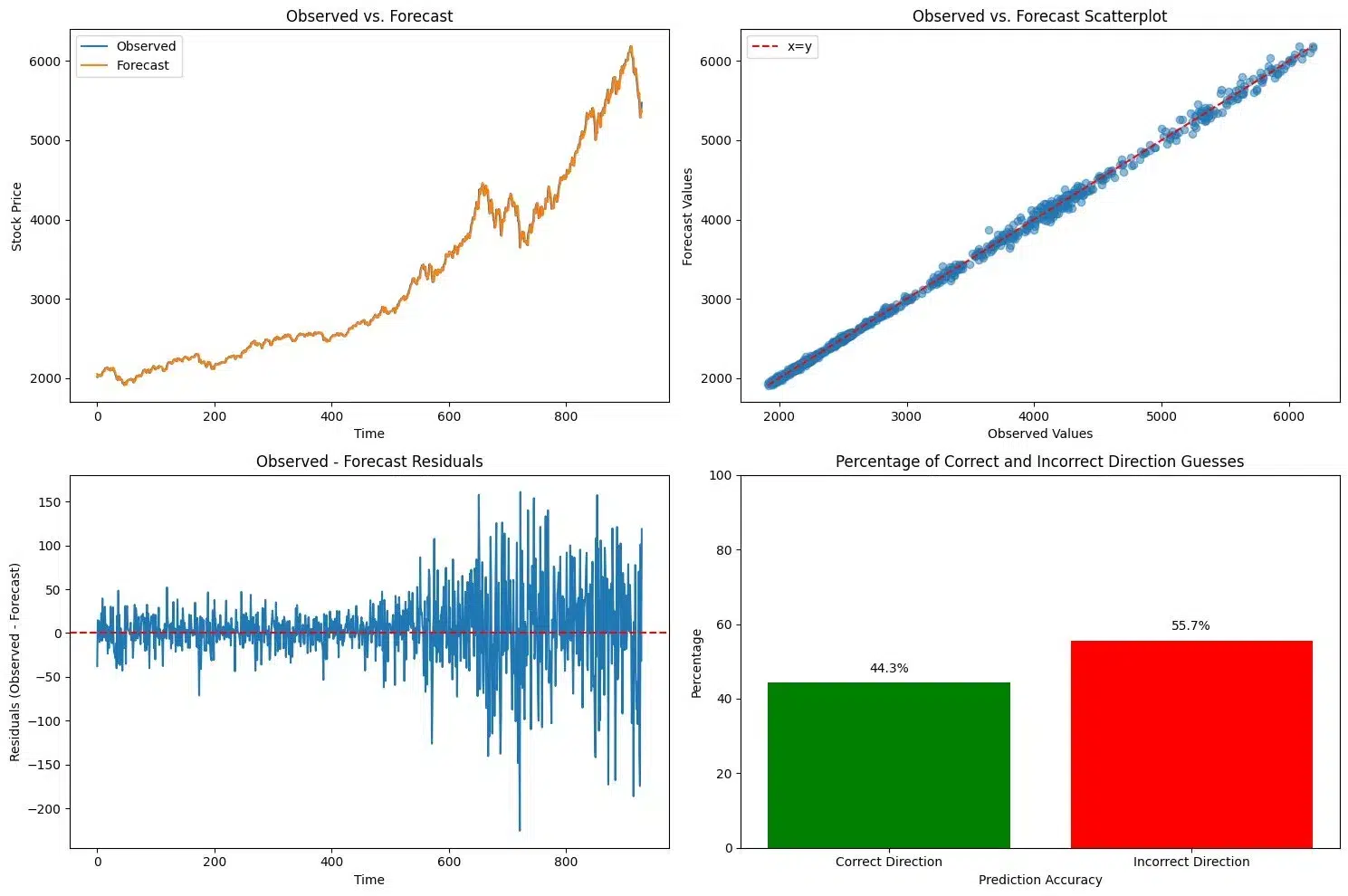

I. SCHLUSSFOLGERUNGEN DER STUDIE 1. Allgemeine Schlussfolgerungen Die Ergebnisse dieser Studie zeigen, dass es derzeit möglich ist, in dem lokalen Gebiet

In der heutigen Ära des raschen technologischen Fortschritts sind Techniken der künstlichen Intelligenz (KI) zur Modellierung großer Datenmengen zum Standard geworden.

Machen Sie sich Ihren KI-Assistenten zu eigen und steigern Sie Ihre Produktivität mit nur einem Klick!

öffentliche Nummer

Wirtschaftliche Zusammenarbeit